Guia de Referência do Apache Kafka

Este guia de referência demonstra como sua aplicação Quarkus pode utilizar a Mensageria Quarkus para interagir com o Apache Kafka.

1. Introdução

O Apache Kafka é uma plataforma popular de streaming de eventos distribuídos de código aberto. É comumente usado para pipelines de dados de alto desempenho, análise de streaming, integração de dados e aplicações de missão crítica. Semelhante a uma fila de mensagens ou a uma plataforma de mensagens corporativas, ele permite que você:

-

publique (escreva) e assine (leia) fluxos de eventos, chamados de registros.

-

armazene fluxos de registros de forma durável e confiável dentro de tópicos.

-

processe fluxos de registros à medida que eles ocorrem ou retrospectivamente.

E toda esta funcionalidade é fornecida de uma forma distribuída, altamente escalável, elástica, tolerante a falhas e segura.

2. Extensão Quarkus para Apache Kafka

O Quarkus oferece suporte para Apache Kafka através do framework Mensageria Reativa do SmallRye. Baseado na especificação Eclipse MicroProfile Reactive Messaging 2.0, ela propõe um modelo de programação flexível que conecta CDI e processamento orientado a eventos.

|

Este guia fornece uma visão aprofundada sobre Apache Kafka e o framework SmallRye Reactive Messaging. Para um início rápido, consulte Introdução à Mensageria Quarkus com Apache Kafka. |

Você pode adicionar a extensão messaging-kafka ao seu projeto executando o seguinte comando no diretório base do seu projeto:

quarkus extension add messaging-kafka./mvnw quarkus:add-extension -Dextensions='messaging-kafka'./gradlew addExtension --extensions='messaging-kafka'Isto adicionará o seguinte ao seu arquivo de build:

<dependency>

<groupId>io.quarkus</groupId>

<artifactId>quarkus-messaging-kafka</artifactId>

</dependency>implementation("io.quarkus:quarkus-messaging-kafka")|

A extensão inclui |

3. Configuring SmallRye Kafka Connector

Because SmallRye Reactive Messaging framework supports different messaging backends like Apache Kafka, AMQP, Apache Camel, JMS, MQTT, etc., it employs a generic vocabulary:

-

Aplicações enviam e recebem mensagens. Uma mensagem encapsula um payload e pode ser estendida com alguns metadados. Com o conector Kafka, uma mensagem corresponde a um registro Kafka.

-

As mensagens transitam nos canais. Os componentes da aplicação ligam-se aos canais para publicar e consumir mensagens. O conector Kafka mapeia canais para tópicos Kafka.

-

Os canais são ligados a backends de mensagens através de conectores. Os conectores são configurados para mapear as mensagens de entrada para um canal específico (consumido pela aplicação) e recolher as mensagens de saída enviadas para um canal específico. Cada conector é dedicado a uma tecnologia de mensagens específica. Por exemplo, o conector que lida com o Kafka tem o nome de

smallrye-kafka.

Uma configuração mínima para o conector Kafka com um canal de entrada tem o seguinte aspecto:

%prod.kafka.bootstrap.servers=kafka:9092 (1)

mp.messaging.incoming.prices.connector=smallrye-kafka (2)| 1 | Configure a localização do broker para o perfil de produção. Você pode configurá-lo globalmente ou por canal usando a propriedade mp.messaging.incoming.$channel.bootstrap.servers. No modo de desenvolvimento e ao executar testes, Dev Services para o Kafka inicia automaticamente um broker Kafka. Quando não fornecida, esta propriedade tem o valor padrão localhost:9092. |

| 2 | Configure o conector para gerenciar o canal de preços. Por padrão, o nome do tópico é o mesmo que o nome do canal. Você pode configurar o atributo do tópico para o substituir. |

O prefixo %prod indica que a propriedade só é utilizada quando a aplicação é executada em modo de produção (portanto, não em desenvolvimento ou teste). Consulte a documentação do Perfil para obter mais detalhes.

|

|

Fixação automática do conector

Se você tiver um único conector no classpath, poderá omitir a configuração do atributo Esta ligação automática pode ser desativada utilizando: |

4. Recebendo mensagens do Kafka

Continuando com a configuração mínima anterior, a sua aplicação Quarkus pode receber diretamente a conteúdo da mensagem:

import org.eclipse.microprofile.reactive.messaging.Incoming;

import jakarta.enterprise.context.ApplicationScoped;

@ApplicationScoped

public class PriceConsumer {

@Incoming("prices")

public void consume(double price) {

// process your price.

}

}Existem várias outras formas da sua aplicação consumir mensagens recebidas:

@Incoming("prices")

public CompletionStage<Void> consume(Message<Double> msg) {

// access record metadata

var metadata = msg.getMetadata(IncomingKafkaRecordMetadata.class).orElseThrow();

// process the message payload.

double price = msg.getPayload();

// Acknowledge the incoming message (commit the offset)

return msg.ack();

}O tipo Message permite que o método consumidor acesse os metadados da mensagem recebida e manipule a confirmação manualmente. Iremos explorar diferentes estratégias de confirmação em Estratégias de Confirmação.

Se você pretende acessar diretamente os objetos do registro Kafka, utilize:

@Incoming("prices")

public void consume(ConsumerRecord<String, Double> record) {

String key = record.key(); // Can be `null` if the incoming record has no key

String value = record.value(); // Can be `null` if the incoming record has no value

String topic = record.topic();

int partition = record.partition();

// ...

}ConsumerRecord é fornecido pelo cliente Kafka subjacente e pode ser injetado diretamente no método do consumidor. Outra abordagem mais simples consiste em usar Record:

@Incoming("prices")

public void consume(Record<String, Double> record) {

String key = record.key(); // Can be `null` if the incoming record has no key

String value = record.value(); // Can be `null` if the incoming record has no value

}Record é um simples encapsulador em torno da chave e do conteúdo do registro Kafka recebido.

Alternativamente, sua aplicação pode injetar um Multi no seu bean e assinar os seus eventos, como no exemplo seguinte:

import io.smallrye.mutiny.Multi;

import org.eclipse.microprofile.reactive.messaging.Channel;

import jakarta.inject.Inject;

import jakarta.ws.rs.GET;

import jakarta.ws.rs.Path;

import jakarta.ws.rs.Produces;

import jakarta.ws.rs.core.MediaType;

import org.jboss.resteasy.reactive.RestStreamElementType;

@Path("/prices")

public class PriceResource {

@Inject

@Channel("prices")

Multi<Double> prices;

@GET

@Path("/prices")

@RestStreamElementType(MediaType.TEXT_PLAIN)

public Multi<Double> stream() {

return prices;

}

}Esse é um bom exemplo de como integrar um consumidor Kafka com outro downstream, neste exemplo, expondo-o como um endpoint Server-Sent Events.

|

Ao consumir mensagens com |

Os seguintes tipos podem ser injetados como canais:

@Inject @Channel("prices") Multi<Double> streamOfPayloads;

@Inject @Channel("prices") Multi<Message<Double>> streamOfMessages;

@Inject @Channel("prices") Publisher<Double> publisherOfPayloads;

@Inject @Channel("prices") Publisher<Message<Double>> publisherOfMessages;Assim como no exemplo anterior com Message, se o seu canal injetado recebe payloads (Multi<T>), ele reconhece a mensagem automaticamente e suporta múltiplos assinantes. Se o seu canal injetado recebe Mensagem (Multi<Message<T>>), você será responsável pela confirmação e transmissão. Iremos explorar o envio de mensagens de transmissão em Difusão de mensagens em vários consumidores.

|

Injetar |

4.1. Bloqueando o processamento

A Mensageria Reativa invoca seu método em um thread de E/S. Consulte a documentação da Arquitetura Reativa do Quarkus para obter mais detalhes sobre esse tópico. Mas, muitas vezes, você precisa combinar o envio de mensagens reativas com processamento blocante, como interações de banco de dados. Para isso, você precisa usar a anotação @Blocking indicando que o processamento está bloqueando e não deve ser executado no thread do chamador.

Por exemplo, o código a seguir ilustra como é possível armazenar conteúdos recebidos em uma base de dados usando o Hibernate com Panache:

import io.smallrye.reactive.messaging.annotations.Blocking;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import jakarta.enterprise.context.ApplicationScoped;

import jakarta.transaction.Transactional;

@ApplicationScoped

public class PriceStorage {

@Incoming("prices")

@Transactional

public void store(int priceInUsd) {

Price price = new Price();

price.value = priceInUsd;

price.persist();

}

}O exemplo completo está disponível nodiretório kafka-panache-quickstart.

|

Existem 2 anotações de

Eles têm o mesmo efeito. Portanto, você pode usar os dois. O primeiro fornece um ajuste mais refinado, como o pool de trabalho a ser usado e se ele preserva a ordem. O segundo, usado também com outros recursos reativos do Quarkus, usa o pool de trabalho padrão e preserva a ordem. Informações detalhadas sobre a utilização da anotação |

|

@RunOnVirtualThread

Para executar o processamento blocante em threads virtuais Java, consulte a documentação de suporte do Quarkus à Virtual Thread com Mensageria Reativa. |

|

@Transactional

Se o seu método estiver anotado com |

4.2. Estratégias de Reconhecimento

Todas as mensagens recebidas por um consumidor devem ser confirmadas. Na ausência de confirmação, o processamento é considerado um erro. Se o método do consumidor receber um Record ou um conteúdo, a mensagem será confirmada no retorno do método, também conhecido como Strategy.POST_PROCESSING. Se o método do consumidor retornar outro fluxo reativo ou CompletionStage, a mensagem será confirmada quando a mensagem downstream for confirmada. Você pode substituir o comportamento padrão para acessar a mensagem na chegada (Strategy.PRE_PROCESSING) ou não acessar a mensagem de forma alguma (Strategy.NONE) no método do consumidor, como no exemplo a seguir:

@Incoming("prices")

@Acknowledgment(Acknowledgment.Strategy.PRE_PROCESSING)

public void process(double price) {

// process price

}Se o método consumidor receber uma Message, a estratégia de reconhecimento será Strategy.MANUAL e o método consumidor será responsável por reconhecer/não reconhecer a mensagem.

@Incoming("prices")

public CompletionStage<Void> process(Message<Double> msg) {

// process price

return msg.ack();

}Como mencionado acima, o método também pode substituir a estratégia de confirmação para PRE_PROCESSING ou NONE.

4.3. Estratégias de Confirmação

Quando uma mensagem produzida a partir de um registro do Kafka é reconhecida, o conector invoca uma estratégia de confirmação. Essas estratégias decidem quando o deslocamento do consumidor para um tópico/partição específico é confirmado. A confirmação de um deslocamento indica que todos os registros anteriores foram processados. É também a posição em que a aplicação reiniciaria o processamento após uma recuperação de falha ou uma reinicialização.

A confirmação de cada deslocamento tem penalidades de desempenho, pois o gerenciamento de deslocamento do Kafka pode ser lento. No entanto, não confirmar o deslocamento com frequência suficiente pode levar à duplicação de mensagens se a aplicação falhar entre duas confirmações.

O conector Kafka suporta três estratégias:

-

throttledmantém o controle das mensagens recebidas e confirma um deslocamento da última mensagem recebida em sequência (ou seja, todas as mensagens anteriores também foram recebidas). Essa estratégia garante a entrega pelo menos uma vez, mesmo que o canal execute o processamento assíncrono. O conector rastreia os registros recebidos e periodicamente (período especificado porauto.commit.interval.ms, padrão: 5000 ms) confirma o maior deslocamento consecutivo. O conector será marcado como não saudável se uma mensagem associada a um registro não for confirmada emthrottled.unprocessed-record-max-age.ms(padrão: 60000 ms). Na verdade, essa estratégia não pode confirmar o deslocamento assim que houver falha no processamento de um único registro. Sethrottled.unprocessed-record-max-age.msfor definido como menor ou igual a0, ele não realizará nenhuma verificação de integridade. Essa configuração pode levar à falta de memória se houver mensagens do tipo "pílula de veneno" (que nunca são aceitas). Essa estratégia é o padrão seenable.auto.commitnão estiver explicitamente definido como verdadeiro. -

checkpointpermite persistir os offsets do consumidor em um state store, em vez de registra-los de volta para o broker Kafka. Usando a APICheckpointMetadata, o código do consumidor pode persistir um processing state com o offset do registro para marcar o progresso de um consumidor. Quando o processamento continua a partir de um offset previamente persistido, ele posiciona o consumidor Kafka nesse offset e também restaura o estado persistido, continuando o processamento com estado de onde parou. A estratégia de checkpoint mantém localmente o estado de processamento associado ao último offset e o persiste periodicamente no state store (período especificado porauto.commit.interval.ms(padrão: 5000)). O conector será marcado como não saudável se nenhum estado de processamento for persistido no state store emcheckpoint.unsynced-state-max-age.ms(padrão: 10000). Secheckpoint.unsynced-state-max-age.msfor definido como menor ou igual a 0, ele não realizará nenhuma verificação de saúde. Para mais informações, consulte Processamento com estado com Ponto de Verificação. -

latestconfirma o offset do registro recebido pelo consumidor Kafka assim que a mensagem associada é reconhecida (se o offset for maior que o offset previamente confirmado). Esta estratégia fornece entrega pelo menos uma vez se o canal processa a mensagem sem realizar nenhum processamento assíncrono. Especificamente, o offset da mensagem mais recentemente reconhecida sempre será confirmado, mesmo que mensagens mais antigas ainda não tenham terminado de ser processadas. Em caso de incidente, como uma falha, o processamento reiniciaria após o último commit, resultando em mensagens mais antigas que nunca foram processadas com sucesso e completamente, o que poderia ser interpretado como perda de mensagem. Esta estratégia não deve ser usada em um ambiente de carga alta, pois a confirmação do offset é custosa. No entanto, ela reduz o risco de duplicatas. -

ignorenão realiza nenhuma confirmação. Essa estratégia é a estratégia padrão quando o consumidor é configurado explicitamente comenable.auto.commitcomo true. Ela delega a confirmação de deslocamento para o cliente Kafka subjacente. Quandoenable.auto.commitétrue, essa estratégia NÃO garante a entrega pelo menos uma vez. A Mensageria Reativa do SmallRye processa registros de forma assíncrona, de modo que os deslocamentos podem ser confirmados para registros que foram pesquisados, mas ainda não processados. Em caso de falha, apenas os registros que ainda não foram confirmados serão reprocessados.

|

O conector Kafka desativa a confirmação automática do Kafka quando ela não está explicitamente ativada. Esse comportamento difere do consumidor tradicional do Kafka. Se a alta taxa de transferência for importante para você, e se não estiver limitado pelo downstream, recomendamos:

|

SmallRye Reactive Messaging enables implementing custom commit strategies. See SmallRye Reactive Messaging documentation for more information.

4.4. Estratégias de Tratamento de Erros

Se uma mensagem produzida a partir de um registro Kafka não for enviada, é aplicada uma estratégia de falha. O conector Kafka suporta três estratégias:

-

fail: falha a aplicação, não serão processados mais registros (estratégia padrão). O deslocamento do registro que não foi processado corretamente não é confirmado. -

ignore: a falha é registrada, mas o processamento continua. O deslocamento do registro que não foi processado corretamente é confirmado. -

dead-letter-queue: o deslocamento do registro que não foi processado corretamente é confirmado, mas o registro é escrito em um tópico de letra morta do Kafka.

A estratégia é selecionada utilizando o atributo failure-strategy.

No caso do dead-letter-queue, você pode configurar os seguintes atributos:

-

dead-letter-queue.topic: o tópico usado para escrever os registros não processados corretamente, o padrão édead-letter-topic-$channel, sendo$channelo nome do canal. -

dead-letter-queue.key.serializer: o serializador usado para escrever a chave de registro na fila de letra morta. Por padrão, o serializador é deduzido a partir do desserializador da chave. -

dead-letter-queue.value.serializer: o serializador usado para escrever o valor do registro na fila de letras mortas. Por padrão, o serializador é deduzido a partir do desserializador do valor.

O registro escrito na fila de cartas mortas contém um conjunto de cabeçalhos adicionais sobre o registro original:

-

dead-letter-reason: o motivo da falha

-

dead-letter-cause: a causa da falha, se houver

-

dead-letter-topic: o tópico original do registro

-

dead-letter-partition: a partição original do registro (inteiro mapeado para String)

-

dead-letter-deslocamento: o deslocamento original do registro (long mapeado para String)

SmallRye Reactive Messaging enables implementing custom failure strategies. See SmallRye Reactive Messaging documentation for more information.

4.4.1. Repetindo o processamento

Você pode combinar a Mensageria Reativa com a Tolerância a Falhas do SmallRye e tentar novamente o processamento em caso de falha:

@Incoming("kafka")

@Retry(delay = 10, maxRetries = 5)

public void consume(String v) {

// ... retry if this method throws an exception

}Você pode configurar o atraso, o número de tentativas, o jitter, etc.

Se o método devolver um Uni ou CompletionStage, é necessário acrescentar a anotação @NonBlocking:

@Incoming("kafka")

@Retry(delay = 10, maxRetries = 5)

@NonBlocking

public Uni<String> consume(String v) {

// ... retry if this method throws an exception or the returned Uni produce a failure

}

A anotação @NonBlocking só é necessária com a Tolerância a Falha do SmallRye 5.1.0 e versões anteriores. A partir da Tolerância a Falha do SmallRye 5.2.0 (disponível desde o Quarkus 2.1.0.Final), ela não é necessária. Consulte a documentação da Tolerância a Falha do SmallRye para obter mais informações.

|

As mensagens recebidas são reconhecidas somente quando o processamento é concluído com êxito. Portanto, ele confirma o deslocamento após o processamento bem-sucedido. Se o processamento ainda falhar, mesmo depois de todas as tentativas, a mensagem será não reconhecida e a estratégia de falha será aplicada.

4.4.2. Tratando Falhas de Desserialização

Quando ocorre uma falha na desserialização, você pode interceptá-la e fornecer uma estratégia de falha. Para isso, você precisa criar um bean que implemente a interface DeserializationFailureHandler<T>:

@ApplicationScoped

@Identifier("failure-retry") // Set the name of the failure handler

public class MyDeserializationFailureHandler

implements DeserializationFailureHandler<JsonObject> { // Specify the expected type

@Override

public JsonObject decorateDeserialization(Uni<JsonObject> deserialization, String topic, boolean isKey,

String deserializer, byte[] data, Headers headers) {

return deserialization

.onFailure().retry().atMost(3)

.await().atMost(Duration.ofMillis(200));

}

}Para utilizar este manipulador de falhas, o bean deve ser exposto com o qualificador @Identifier e a configuração do conector deve especificar o atributo mp.messaging.incoming.$channel.[key|value]-deserialization-failure-handler (para desserializadores de chave ou de valor).

O manipulador é chamado com detalhes da desserialização, inclusive a ação representada como Uni<T>. Na desserialização Uni podem ser implementadas estratégias de falha, como tentar novamente, fornecer um valor de reserva ou aplicar o tempo limite.

Se você não configurar um manipulador de falha de desserialização e ocorrer uma falha de desserialização, a aplicação será marcada como não saudável. Você também pode ignorar a falha, o que registrará a exceção e produzirá um valor null. Para habilitar esse comportamento, configure o atributo mp.messaging.incoming.$channel.fail-on-deserialization-failure para false.

Se o atributo fail-on-deserialization-failure estiver configurado como false e o atributo failure-strategy for dead-letter-queue, o registro com falha será enviado para o tópico da dead letter queue correspondente.

4.5. Grupos de Consumidores

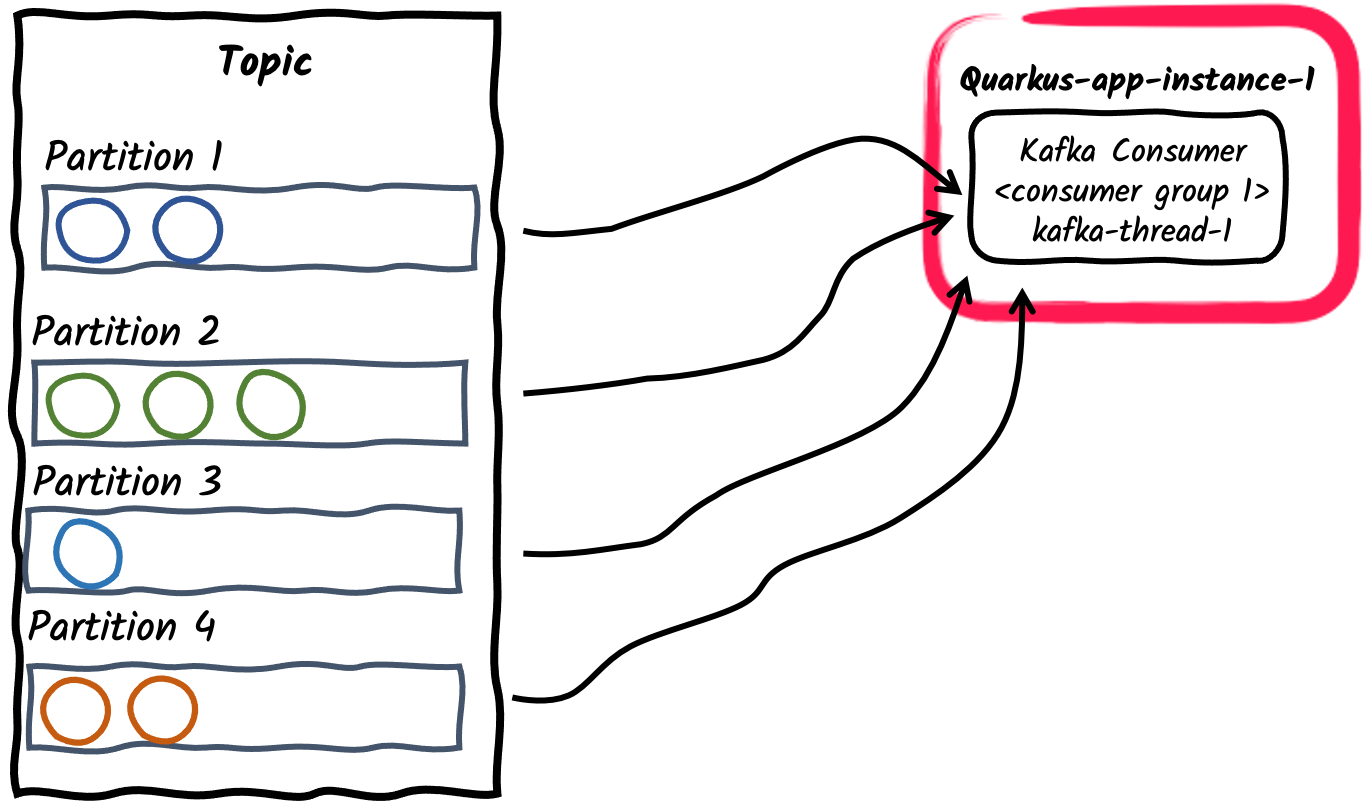

No Kafka, um grupo de consumidores é um conjunto de consumidores que cooperam para consumir dados de um tópico. Um tópico é dividido em um conjunto de partições. As partições de um tópico são atribuídas entre os consumidores do grupo, o que permite dimensionar efetivamente a taxa de transferência do consumo. Observe que cada partição é atribuída a um único consumidor de um grupo. No entanto, um consumidor pode ser atribuído a várias partições se o número de partições for maior que o número de consumidores no grupo.

Vamos explorar brevemente diferentes padrões de produtor/consumidor e como implementá-los usando o Quarkus:

-

Uma única thread de consumidor dentro de um grupo de consumidores

Esse é o comportamento padrão de uma aplicação que se inscreve em um tópico do Kafka: Cada conector Kafka criará um único thread de consumidor e o colocará em um único grupo de consumidores. O ID do grupo de consumidores tem como padrão o nome da aplicação, conforme definido pela propriedade de configuração

quarkus.application.name. Ele também pode ser definido por meio da propriedadekafka.group.id.

-

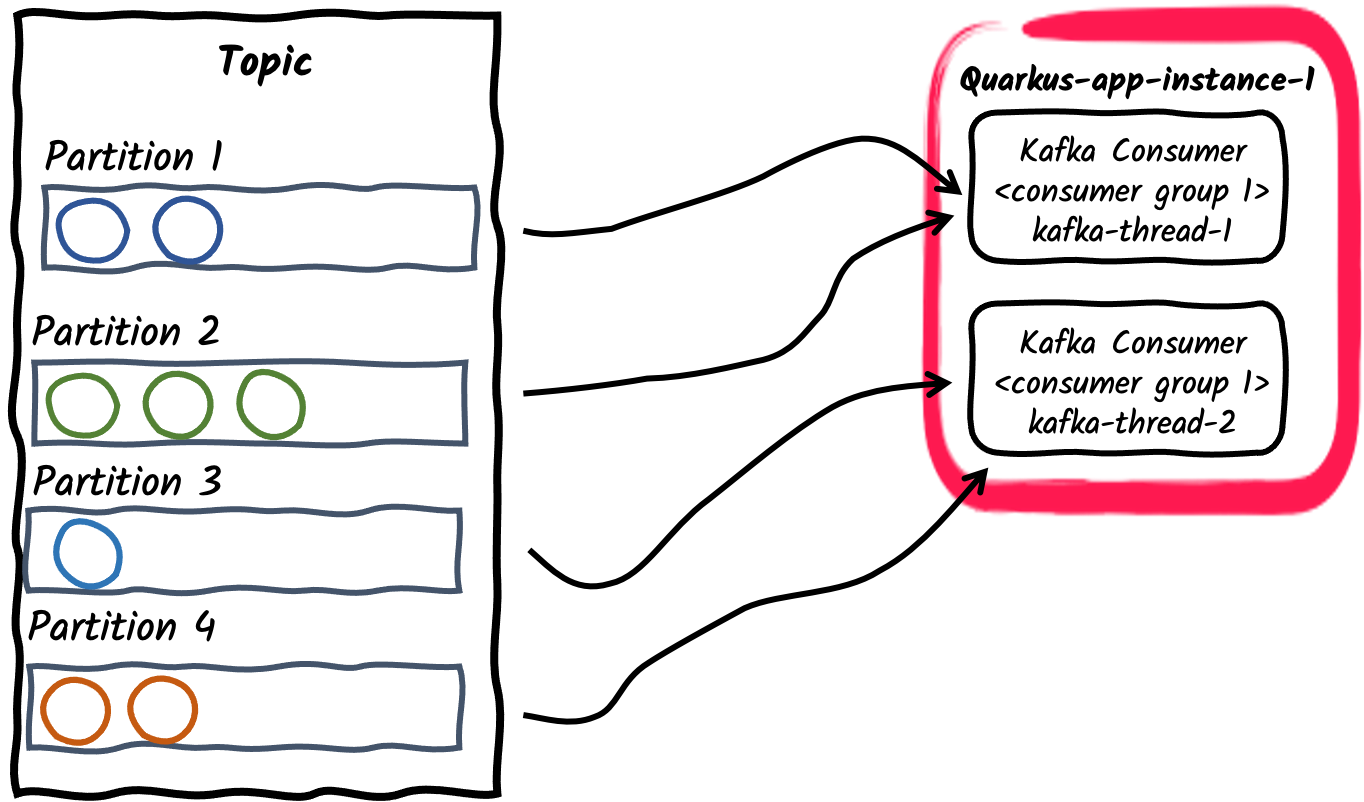

Vários threads de consumidores em um grupo de consumidores

Para uma determinada instância da aplicação, o número de consumidores dentro do grupo de consumidores pode ser configurado usando a propriedade mp.messaging.incoming.$channel.concurrency. As partições do tópico assinado serão divididas entre as threads de consumidores. Observe que se o valor de concorrência exceder o número de partições do tópico, algumas threads de consumidores não serão atribuídas a nenhuma partição.

Depreciação

DepreciaçãoO atributo de concorrência fornece uma maneira agnóstica de conector para canais concorrentes não blocantes e substitui o atributo

partitionsespecífico do conector Kafka. O atributopartitionsestá, portanto, obsoleto e será removido em versões futuras. -

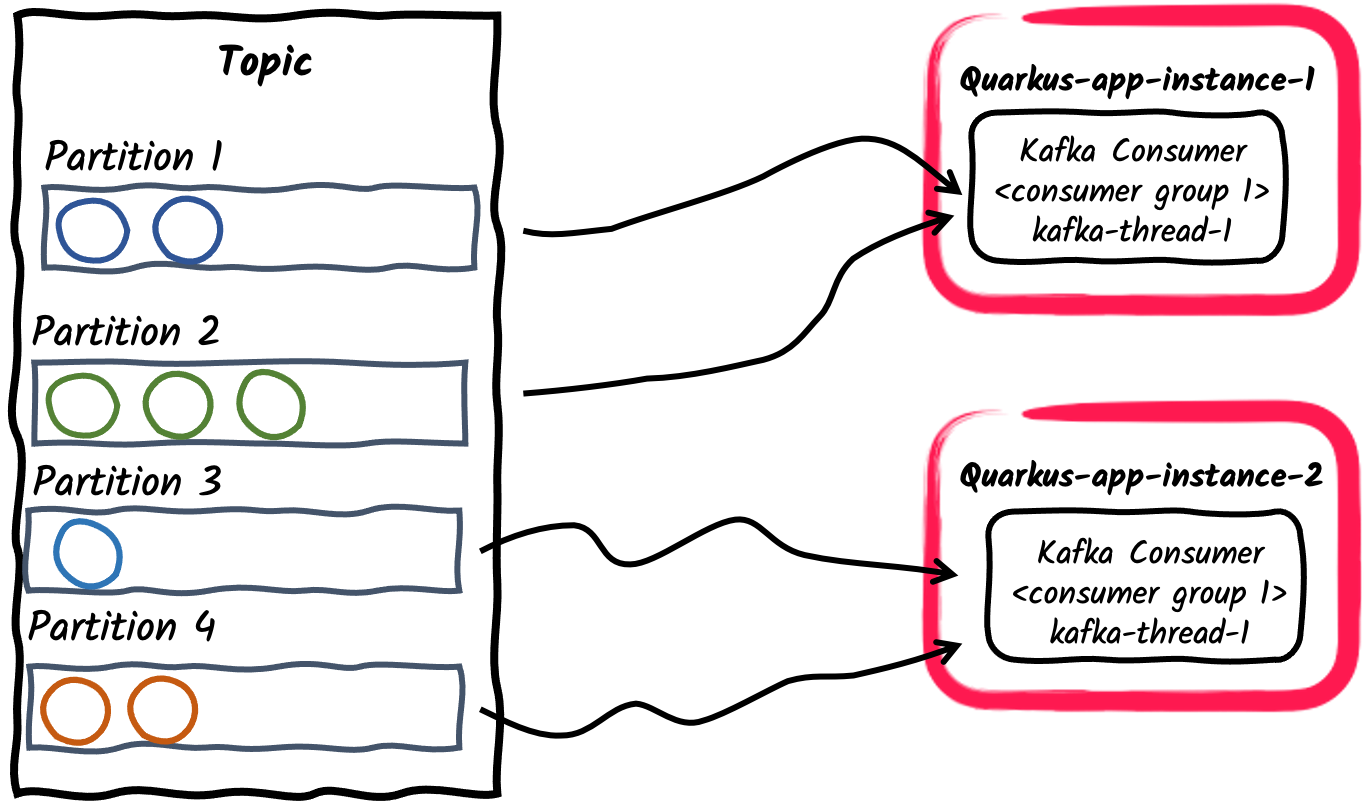

Várias aplicações de consumo dentro de um grupo de consumidores

Da mesma forma que no exemplo anterior, várias instâncias de uma aplicação podem se inscrever em um único grupo de consumidores, configurado por meio da propriedade

mp.messaging.incoming.$channel.group.idou deixado como padrão para o nome da aplicação. Isso, por sua vez, dividirá as partições do tópico entre as instâncias da aplicação.

-

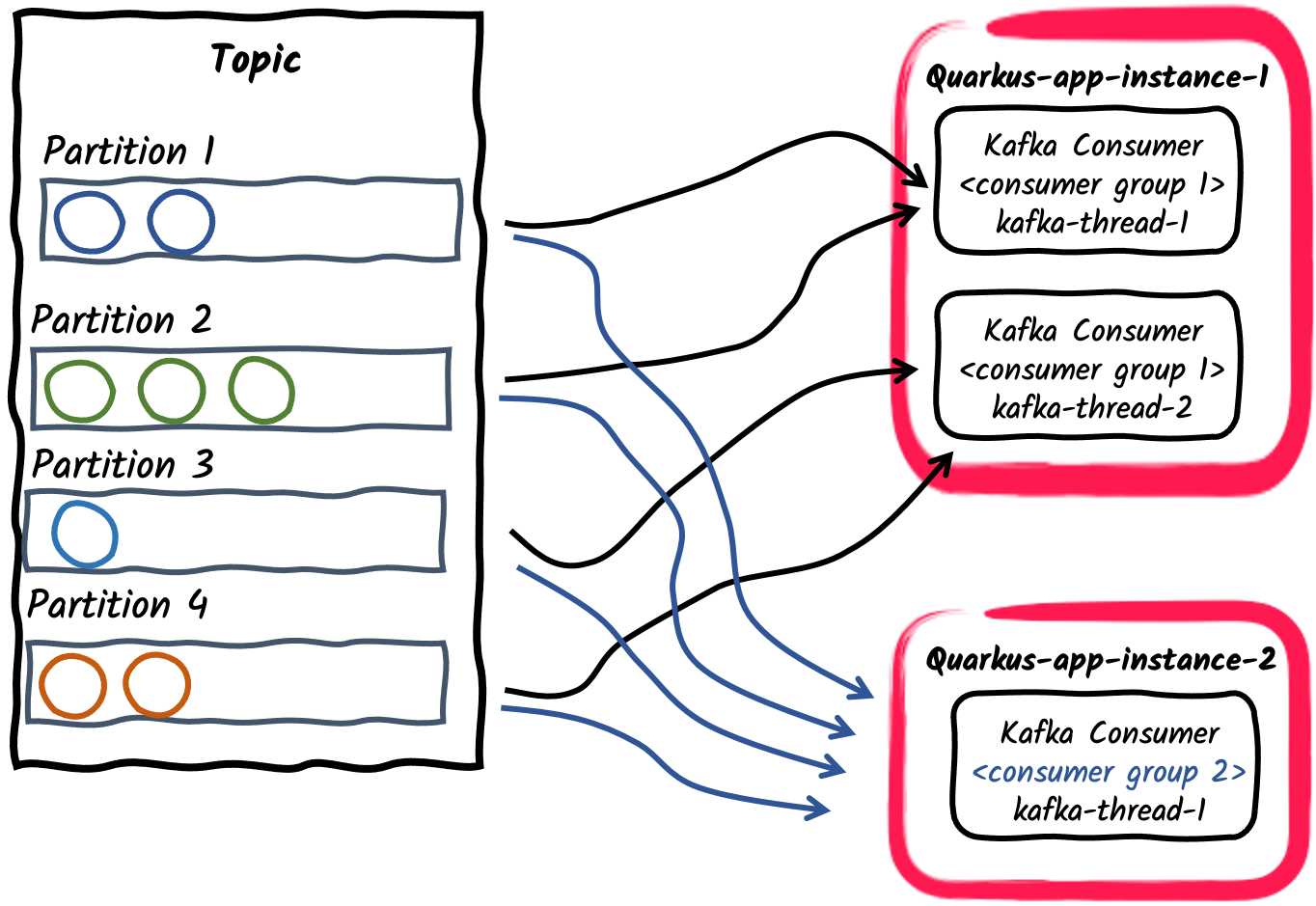

Pub/Sub: Vários grupos de consumidores inscritos em um tópico

Por fim, diferentes aplicações podem se inscrever independentemente nos mesmos tópicos usando diferentes IDs de grupos de consumidores. Por exemplo, as mensagens publicadas em um tópico chamado pedidos podem ser consumidas de forma independente em duas aplicações de consumo, uma com

mp.messaging.incoming.orders.group.id=invoicinge a segunda commp.messaging.incoming.orders.group.id=shipping. Assim, diferentes grupos de consumidores podem ser dimensionados de forma independente de acordo com os requisitos de consumo de mensagens.

|

Um requisito negocial comum é consumir e processar os registros do Kafka em ordem. O broker Kafka preserva a ordem dos registros dentro de uma partição e não dentro de um tópico. Portanto, é importante pensar em como os registros são particionados dentro de um tópico. O particionador padrão usa o hash da chave do registro para calcular a partição de um registro ou, quando a chave não é definida, escolhe uma partição aleatoriamente por lote ou registros. During normal operation, a Kafka consumer preserves the order of records inside each partition assigned to it.

SmallRye Reactive Messaging keeps this order for processing, unless Note que, devido aos rebalanceamentos dos consumidores, os consumidores Kafka apenas garantem o processamento pelo menos uma vez de registros individuais, o que significa que os registros não confirmados podem ser processados novamente pelos consumidores. |

4.5.1. Listener de Rebalanceamento do Consumidor

Em um grupo de consumidores, à medida que novos membros do grupo chegam e membros antigos saem, as partições são reatribuídas para que cada membro receba uma parte proporcional das partições. Isso é conhecido como rebalanceamento do grupo. Para lidar com a confirmação de deslocamento e as partições atribuídas, você pode fornecer um listener de rebalanceamento de consumidor. Para isso, implemente a interface io.smallrye.reactive.messaging.kafka.KafkaConsumerRebalanceListener e exponha-a como um bean CDI com o qualificador @Idenfier. Um caso de uso comum é armazenar o deslocamento em um armazém de dados separado para implementar a semântica exatamente único ou iniciar o processamento em um deslocamento específico.

O listener é chamado sempre que a atribuição de tópico/partição do consumidor é alterada. Por exemplo, quando a aplicação é iniciada, ele invoca call-back partitionsAssigned com o conjunto inicial de tópicos/partições associados ao consumidor. Se, mais tarde, esse conjunto for alterado, ele chama novamente os callbacks partitionsRevoked e partitionsAssigned, para que você possa implementar uma lógica personalizada.

Observe que os métodos do ouvinte de rebalanceamento são chamados a partir da thread de polling do Kafka e bloquearão a thread do chamador até a conclusão. Isso ocorre porque o protocolo de rebalanceamento tem barreiras de sincronização, e o uso de código assíncrono em um ouvinte de rebalanceamento pode ser executado após a barreira de sincronização.

Quando os tópicos/partições são atribuídos ou revogados por um consumidor, o envio de mensagens é interrompido e retomado após a conclusão do rebalanceamento.

Se o ouvinte de rebalanceamento lidar com a confirmação de deslocamento em nome do usuário (usando a estratégia de confirmação NONE), o ouvinte de rebalanceamento deverá confirmar o deslocamento de forma síncrona na chamada de retorno partitionsRevoked. Também recomendamos aplicar a mesma lógica quando a aplicação for interrompida.

Ao contrário dos métodos ConsumerRebalanceListener do Apache Kafka, os métodos io.smallrye.reactive.messaging.kafka.KafkaConsumerRebalanceListener transmitem o consumidor Kafka e o conjunto de tópicos/partições.

No exemplo a seguir, configuramos um consumidor que sempre inicia com mensagens de, no máximo, 10 minutos atrás (ou deslocamento 0). Primeiro, precisamos fornecer um bean que implemente io.smallrye.reactive.messaging.kafka.KafkaConsumerRebalanceListener e seja anotado com io.smallrye.common.annotation.Identifier. Em seguida, devemos configurar nosso conector de entrada para usar esse bean.

package inbound;

import io.smallrye.common.annotation.Identifier;

import io.smallrye.reactive.messaging.kafka.KafkaConsumerRebalanceListener;

import org.apache.kafka.clients.consumer.Consumer;

import org.apache.kafka.clients.consumer.OffsetAndTimestamp;

import org.apache.kafka.clients.consumer.TopicPartition;

import jakarta.enterprise.context.ApplicationScoped;

import java.util.Collection;

import java.util.HashMap;

import java.util.Map;

import java.util.logging.Logger;

@ApplicationScoped

@Identifier("rebalanced-example.rebalancer")

public class KafkaRebalancedConsumerRebalanceListener implements KafkaConsumerRebalanceListener {

private static final Logger LOGGER = Logger.getLogger(KafkaRebalancedConsumerRebalanceListener.class.getName());

/**

* When receiving a list of partitions, will search for the earliest offset within 10 minutes

* and seek the consumer to it.

*

* @param consumer underlying consumer

* @param partitions set of assigned topic partitions

*/

@Override

public void onPartitionsAssigned(Consumer<?, ?> consumer, Collection<TopicPartition> partitions) {

long now = System.currentTimeMillis();

long shouldStartAt = now - 600_000L; //10 minute ago

Map<TopicPartition, Long> request = new HashMap<>();

for (TopicPartition partition : partitions) {

LOGGER.info("Assigned " + partition);

request.put(partition, shouldStartAt);

}

Map<TopicPartition, OffsetAndTimestamp> offsets = consumer.offsetsForTimes(request);

for (Map.Entry<TopicPartition, OffsetAndTimestamp> position : offsets.entrySet()) {

long target = position.getValue() == null ? 0L : position.getValue().offset();

LOGGER.info("Seeking position " + target + " for " + position.getKey());

consumer.seek(position.getKey(), target);

}

}

}package inbound;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.eclipse.microprofile.reactive.messaging.Acknowledgment;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Message;

import jakarta.enterprise.context.ApplicationScoped;

import java.util.concurrent.CompletableFuture;

import java.util.concurrent.CompletionStage;

@ApplicationScoped

public class KafkaRebalancedConsumer {

@Incoming("rebalanced-example")

@Acknowledgment(Acknowledgment.Strategy.NONE)

public CompletionStage<Void> consume(Message<ConsumerRecord<Integer, String>> message) {

// We don't need to ACK messages because in this example,

// we set offset during consumer rebalance

return CompletableFuture.completedFuture(null);

}

}Para configurar o conector de entrada para usar o ouvinte fornecido, definimos o identificador do ouvinte de rebalanceamento do consumidor: mp.messaging.incoming.rebalanced-example.consumer-rebalance-listener.name=rebalanced-example.rebalancer

Ou fazer com que o nome do ouvinte seja o mesmo que o ID do grupo:

mp.messaging.incoming.rebalanced-example.group.id=rebalanced-example.rebalancer

A definição do nome do ouvinte de rebalanceamento do consumidor tem precedência sobre a utilização do ID do grupo.

4.5.2. Utilizando grupos de consumidores únicos

Para processar todos os registros de um tópico (desde o seu início), é necessário:

-

definir

auto.deslocamento.reset = earliest -

atribuir o seu consumidor a um grupo de consumidores não utilizado por nenhuma outra aplicação.

O Quarkus gera um UUID que muda entre duas execuções (inclusive no modo de desenvolvimento). Assim, você tem certeza de que nenhum outro consumidor o utiliza e recebe um novo ID de grupo exclusivo sempre que a aplicação é iniciada.

Você pode utilizar esse UUID gerado como o grupo de consumidores da seguinte forma:

mp.messaging.incoming.your-channel.auto.offset.reset=earliest

mp.messaging.incoming.your-channel.group.id=${quarkus.uuid}

Se o atributo group.id não estiver definido, a propriedade de configuração quarkus.application.name é utilizada por padrão.

|

4.5.3. Atribuição manual de tópico-partição

O atributo de canal assign-seek permite atribuir manualmente tópico-partição a um canal de entrada do Kafka, e, opcionalmente, buscar um deslocamento especificado na partição para começar a consumir registros. Se assign-seek for usado, o consumidor não será inscrito dinamicamente nos tópicos, mas, em vez disso, atribuirá estaticamente as partições descritas. No tópico-partição manual o rebalanceamento não ocorre e, portanto, os ouvintes de rebalanceamento nunca são chamados.

O atributo recebe uma lista de triplas separadas por vírgulas: <topic>:<partition>:<deslocamento>.

Por exemplo, a configuração

mp.messaging.incoming.data.assign-seek=topic1:0:10, topic2:1:20atribui o consumidor à:

-

Partição 0 do tópico 'topic', configurando a posição inicial no deslocamento 10.

-

Partição 1 do tópico 'topic2', configurando a posição inicial no deslocamento 20.

O tópico, partição, e deslocamento em cada tripla pode ter as seguintes variações:

-

Se o tópico for omitido, o tópico configurado será usado.

-

Se o deslocamento for omitido, partições são atribuídas para o consumidor mas não serão buscadas para o deslocamento.

-

Se o deslocamento é 0, ele busca o início do tópico-partição.

-

Se o deslocamento é -1, ele busca o fim do tópico-partição.

4.6. Recebendo Registros Kafka em Lotes

Por padrão, os métodos de entrada recebem cada registro do Kafka individualmente. Por trás disso, os clientes consumidores do Kafka consultam o broker constantemente e recebem registros em lotes, apresentados dentro do contêiner ConsumerRecords.

No modo batch, a sua aplicação pode receber todos os registros devolvidos pela consulta do consumidor de uma só vez.

Para tal, é necessário especificar um tipo de contêiner compatível para receber todos os dados:

@Incoming("prices")

public void consume(List<Double> prices) {

for (double price : prices) {

// process price

}

}O método incoming também pode receber os tipos Message<List<Payload>>, Message<ConsumerRecords<Key, Payload>> e ConsumerRecords<Key, Payload>. Eles fornecem acesso aos detalhes do registro, como offset ou timestamp:

@Incoming("prices")

public CompletionStage<Void> consumeMessage(Message<ConsumerRecords<String, Double>> records) {

for (ConsumerRecord<String, Double> record : records.getPayload()) {

String payload = record.getPayload();

String topic = record.getTopic();

// process messages

}

// ack will commit the latest offsets (per partition) of the batch.

return records.ack();

}Observe que o processamento bem-sucedido do lote de registros de entrada confirmará os deslocamentos mais recentes de cada partição recebida dentro do lote. A estratégia de confirmação configurada será aplicada somente a esses registros.

Inversamente, se o processamento lançar uma exceção, todas as mensagens são não reconhecidas, aplicando a estratégia de falha a todos os registros dentro do lote.

|

O Quarkus detecta automaticamente os tipos de lote para os canais de entrada e define a configuração do lote automaticamente. Você pode configurar o modo de lote explicitamente com a propriedade |

4.7. Processamento com estado com Ponto de Verificação

|

A estratégia de submissão |

SmallRye Reactive Messaging checkpoint commit strategy allows consumer applications to process messages in a stateful manner, while also respecting Kafka consumer scalability.

An incoming channel with checkpoint commit strategy persists consumer offsets on an external

state store, such as a relational database or a key-value store.

As a result of processing consumed records, the consumer application can accumulate an internal state for each topic-partition assigned to the Kafka consumer.

This local state will be periodically persisted to the state store and will be associated with the offset of the record that produced it.

Essa estratégia não confirma nenhum deslocamento para o broker Kafka, portanto, quando novas partições são atribuídas ao consumidor, ou seja, o consumidor é reiniciado ou as instâncias do grupo de consumidores são escalonadas, o consumidor retoma o processamento a partir do último deslocamento do ponto de verificação com seu estado salvo.

O código do consumidor do canal @Incoming pode manipular o estado de processamento por meio da API CheckpointMetadata. Por exemplo, um consumidor que calcula a média móvel dos preços recebidos em um tópico do Kafka teria a seguinte aparência:

package org.acme;

import java.util.concurrent.CompletionStage;

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Message;

import io.smallrye.reactive.messaging.kafka.KafkaRecord;

import io.smallrye.reactive.messaging.kafka.commit.CheckpointMetadata;

@ApplicationScoped

public class MeanCheckpointConsumer {

@Incoming("prices")

public CompletionStage<Void> consume(Message<Double> record) {

// Get the `CheckpointMetadata` from the incoming message

CheckpointMetadata<AveragePrice> checkpoint = CheckpointMetadata.fromMessage(record);

// `CheckpointMetadata` allows transforming the processing state

// Applies the given function, starting from the value `0.0` when no previous state exists

checkpoint.transform(new AveragePrice(), average -> average.update(record.getPayload()), /* persistOnAck */ true);

// `persistOnAck` flag set to true, ack will persist the processing state

// associated with the latest offset (per partition).

return record.ack();

}

static class AveragePrice {

long count;

double mean;

AveragePrice update(double newPrice) {

mean += ((newPrice - mean) / ++count);

return this;

}

}

}O método transform aplica a função de transformação ao estado atual, produzindo um estado alterado e registrando-o localmente para checkpointing. Por padrão, o estado local é mantido no armazém de estado periodicamente, período especificado por auto.commit.interval.ms, (padrão: 5000). Se o sinalizador persistOnAck for fornecido, o estado mais recente será persistido no armazém de estado ansiosamente no reconhecimento da mensagem. O método setNext funciona de forma semelhante, definindo diretamente o estado mais recente.

A estratégia de confirmação de ponto de verificação rastreia quando um estado de processamento foi mantido pela última vez para cada partição de tópico. Se uma alteração de estado pendente não puder ser mantida por checkpoint.unsynced-state-max-age.ms (padrão: 10000), o canal será marcado como não saudável.

4.7.1. State stores (armazéns de estado)

As implementações de armazém de estado determinam onde e como os estados de processamento são mantidos. Isso é configurado pela propriedade mp.messaging.incoming.[channel-name].checkpoint.state-store. A serialização de objetos de estado depende da implementação do armazém de estado. Para instruir os armazéns de estado para serialização, pode ser necessário configurar o nome da classe dos objetos de estado usando a propriedade mp.messaging.incoming.[channel-name].checkpoint.state-type.

O Quarkus fornece as seguintes implementações de armazém de estado:

-

quarkus-redis: Usa a extensãoquarkus-redis-clientpara manter os estados de processamento. Jackson é usado para serializar o estado de processamento em Json. Para objetos complexos, é necessário configurar a propriedadecheckpoint.state-typecom o nome da classe do objeto. Por padrão, o armazém de estado usa o cliente Redis padrão, mas se for necessário usar um cliente nomeado, o nome do cliente poderá ser especificado usando a propriedademp.messaging.incoming.[channel-name].checkpoint.quarkus-redis.client-name. Os estados de processamento serão armazenados no Redis usando o esquema de nomeação de chave[consumer-group-id]:[topic]:[partition].

Por exemplo, a configuração do código anterior seria a seguinte:

mp.messaging.incoming.prices.group.id=prices-checkpoint

# ...

mp.messaging.incoming.prices.commit-strategy=checkpoint

mp.messaging.incoming.prices.checkpoint.state-store=quarkus-redis

mp.messaging.incoming.prices.checkpoint.state-type=org.acme.MeanCheckpointConsumer.AveragePrice

# ...

# if using a named redis client

mp.messaging.incoming.prices.checkpoint.quarkus-redis.client-name=my-redis

quarkus.redis.my-redis.hosts=redis://localhost:7000

quarkus.redis.my-redis.password=<redis-pwd>-

quarkus-hibernate-reactive: Usa a extensão quarkus-hibernate-reactive para manter os estados de processamento. Os objetos de estado de processamento devem ser uma entidade da Jakarta Persistence e estender a classeCheckpointEntity, que lida com identificadores de objeto compostos pelo ID do grupo de consumidores, tópico e partição. Portanto, o nome da classe da entidade precisa ser configurado usando a propriedadecheckpoint.state-type.

Por exemplo, a configuração do código anterior seria a seguinte:

mp.messaging.incoming.prices.group.id=prices-checkpoint

# ...

mp.messaging.incoming.prices.commit-strategy=checkpoint

mp.messaging.incoming.prices.checkpoint.state-store=quarkus-hibernate-reactive

mp.messaging.incoming.prices.checkpoint.state-type=org.acme.AveragePriceEntitySendo AveragePriceEntity uma entidade da Jakarta Persistence que estende CheckpointEntity:

package org.acme;

import jakarta.persistence.Entity;

import io.quarkus.smallrye.reactivemessaging.kafka.CheckpointEntity;

@Entity

public class AveragePriceEntity extends CheckpointEntity {

public long count;

public double mean;

public AveragePriceEntity update(double newPrice) {

mean += ((newPrice - mean) / ++count);

return this;

}

}-

quarkus-hibernate-orm: Usa a extensão quarkus-hibernate-orm para manter os estados de processamento. É semelhante ao armazém de estado anterior, mas usa o Hibernate ORM em vez do Hibernate Reativo.

Quando configurado, ele pode usar um persistence-unit nomeado para o armazém de estado de ponto de verificação:

mp.messaging.incoming.prices.commit-strategy=checkpoint

mp.messaging.incoming.prices.checkpoint.state-store=quarkus-hibernate-orm

mp.messaging.incoming.prices.checkpoint.state-type=org.acme.AveragePriceEntity

mp.messaging.incoming.prices.checkpoint.quarkus-hibernate-orm.persistence-unit=prices

# ... Setup "prices" persistence unit

quarkus.datasource."prices".db-kind=postgresql

quarkus.datasource."prices".username=<your username>

quarkus.datasource."prices".password=<your password>

quarkus.datasource."prices".jdbc.url=jdbc:postgresql://localhost:5432/hibernate_orm_test

quarkus.hibernate-orm."prices".datasource=prices

quarkus.hibernate-orm."prices".packages=org.acmePara obter instruções sobre como implementar armazéns de estado personalizados, consulte Implementando Armazéns de Estado.

5. Enviando mensagens para o Kafka

A configuração dos canais de saída do conector Kafka é semelhante à dos canais de entrada:

%prod.kafka.bootstrap.servers=kafka:9092 (1)

mp.messaging.outgoing.prices-out.connector=smallrye-kafka (2)

mp.messaging.outgoing.prices-out.topic=prices (3)| 1 | Configure a localização do broker para o perfil de produção. Você pode configurá-lo globalmente ou por canal usando a propriedade mp.messaging.outgoing.$channel.bootstrap.servers. No modo de desenvolvimento e ao executar testes, Dev Services para o Kafka inicia automaticamente um broker Kafka. Quando não fornecida, esta propriedade tem o valor padrão localhost:9092. |

| 2 | Configure o conector para gerenciar o canal prices-out. |

| 3 | Por padrão, o nome do tópico é igual ao nome do canal. Você pode configurar o atributo de tópico para o substituir. |

|

Dentro da configuração da aplicação, os nomes dos canais são exclusivos. Portanto, se quiser configurar um canal de entrada e de saída no mesmo tópico, você precisará nomear os canais de forma diferente (como nos exemplos deste guia, |

Em seguida, sua aplicação pode gerar mensagens e publicá-las no canal prices-out. Ele pode usar os conteúdos do double, como no trecho a seguir:

import io.smallrye.mutiny.Multi;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import jakarta.enterprise.context.ApplicationScoped;

import java.time.Duration;

import java.util.Random;

@ApplicationScoped

public class KafkaPriceProducer {

private final Random random = new Random();

@Outgoing("prices-out")

public Multi<Double> generate() {

// Build an infinite stream of random prices

// It emits a price every second

return Multi.createFrom().ticks().every(Duration.ofSeconds(1))

.map(x -> random.nextDouble());

}

}|

Você não deve chamar métodos anotados com |

Observe que o método generate retorna um Multi<Double>, que implementa a interface Publisher do Reactive Streams. Esse publicador será usado pela estrutura para gerar mensagens e enviá-las ao tópico Kafka configurado.

Em vez de devolver uma conteúdo, você pode devolver um io.smallrye.reactive.messaging.kafka.Record para enviar pares de chave/valor:

@Outgoing("out")

public Multi<Record<String, Double>> generate() {

return Multi.createFrom().ticks().every(Duration.ofSeconds(1))

.map(x -> Record.of("my-key", random.nextDouble()));

}O conteúdo pode ser envolvido em uma org.eclipse.microprofile.reactive.messaging.Message para ter mais controle sobre os registros escritos:

@Outgoing("generated-price")

public Multi<Message<Double>> generate() {

return Multi.createFrom().ticks().every(Duration.ofSeconds(1))

.map(x -> Message.of(random.nextDouble())

.addMetadata(OutgoingKafkaRecordMetadata.<String>builder()

.withKey("my-key")

.withTopic("my-key-prices")

.withHeaders(new RecordHeaders().add("my-header", "value".getBytes()))

.build()));

}OutgoingKafkaRecordMetadata permite definir atributos de metadados do registro do Kafka, como key, topic, partition ou timestamp. Um caso de uso é selecionar dinamicamente o tópico de destino de uma mensagem. Nesse caso, em vez de configurar o tópico dentro do arquivo de configuração da aplicação, você precisa usar os metadados de saída para definir o nome do tópico.

Além das assinaturas de método que retornam um Publisher do Reactive Stream (Multi é uma implementação de Publisher), o método de saída também pode retornar uma única mensagem. Nesse caso, o produtor usará esse método como gerador para criar um fluxo infinito.

@Outgoing("prices-out") T generate(); // T excluding void

@Outgoing("prices-out") Message<T> generate();

@Outgoing("prices-out") Uni<T> generate();

@Outgoing("prices-out") Uni<Message<T>> generate();

@Outgoing("prices-out") CompletionStage<T> generate();

@Outgoing("prices-out") CompletionStage<Message<T>> generate();5.1. Enviando de mensagens com o Emitter

Às vezes, você precisa ter uma forma imperativa de enviar mensagens.

Por exemplo, se você precisar enviar uma mensagem para um fluxo ao receber uma solicitação POST dentro de um endpoint REST. Nesse caso, você não pode usar @Outgoing porque seu método tem parâmetros.

Para tal, pode utilizar um Emitter.

import org.eclipse.microprofile.reactive.messaging.Channel;

import org.eclipse.microprofile.reactive.messaging.Emitter;

import jakarta.inject.Inject;

import jakarta.ws.rs.POST;

import jakarta.ws.rs.Path;

import jakarta.ws.rs.Consumes;

import jakarta.ws.rs.core.MediaType;

@Path("/prices")

public class PriceResource {

@Inject

@Channel("price-create")

Emitter<Double> priceEmitter;

@POST

@Consumes(MediaType.TEXT_PLAIN)

public void addPrice(Double price) {

CompletionStage<Void> ack = priceEmitter.send(price);

}

}O envio de um conteúdo devolve um CompletionStage, concluído quando a mensagem é recebida. Se a transmissão da mensagem falhar, o CompletionStage é completado excepcionalmente com a razão do não reconhecimento.

|

A configuração de |

|

Usando o |

Com a API Emitter, você também pode encapsular o payload de saída dentro de Message<T>. Tal como nos exemplos anteriores, Message te permite tratar os casos de reconhecimento/não reconhecimento de forma diferente.

import java.util.concurrent.CompletableFuture;

import org.eclipse.microprofile.reactive.messaging.Channel;

import org.eclipse.microprofile.reactive.messaging.Emitter;

import jakarta.inject.Inject;

import jakarta.ws.rs.POST;

import jakarta.ws.rs.Path;

import jakarta.ws.rs.Consumes;

import jakarta.ws.rs.core.MediaType;

@Path("/prices")

public class PriceResource {

@Inject @Channel("price-create") Emitter<Double> priceEmitter;

@POST

@Consumes(MediaType.TEXT_PLAIN)

public void addPrice(Double price) {

priceEmitter.send(Message.of(price)

.withAck(() -> {

// Called when the message is acked

return CompletableFuture.completedFuture(null);

})

.withNack(throwable -> {

// Called when the message is nacked

return CompletableFuture.completedFuture(null);

}));

}

}Se preferir usar APIs de fluxo reativo, você pode usar MutinyEmitter que retornará Uni<Void> do método send. Portanto, você pode usar as APIs do Mutiny para lidar com mensagens e erros downstream.

import org.eclipse.microprofile.reactive.messaging.Channel;

import jakarta.inject.Inject;

import jakarta.ws.rs.POST;

import jakarta.ws.rs.Path;

import jakarta.ws.rs.Consumes;

import jakarta.ws.rs.core.MediaType;

import io.smallrye.reactive.messaging.MutinyEmitter;

@Path("/prices")

public class PriceResource {

@Inject

@Channel("price-create")

MutinyEmitter<Double> priceEmitter;

@POST

@Consumes(MediaType.TEXT_PLAIN)

public Uni<String> addPrice(Double price) {

return quoteRequestEmitter.send(price)

.map(x -> "ok")

.onFailure().recoverWithItem("ko");

}

}Também é possível bloquear o envio do evento para o emissor com o método sendAndAwait. Ele só retornará do método quando o evento for aceito ou bloqueado pelo receptor.

|

Depreciação

As classes

O novo método |

|

Depreciação

|

Mais informações sobre como usar Emitter podem ser encontradas em Mensageria Reativa do SmallRye - Emissores e Canais

5.2. Escrever Reconhecimento

Quando o broker do Kafka recebe um registro, seu reconhecimento pode demorar, dependendo da configuração. Além disso, ele armazena na memória os registros que não podem ser gravados.

Por padrão, o conector espera que o Kafka confirme o registro para continuar o processamento (reconhecendo a mensagem recebida). Você pode desativar isso definindo o atributo waitForWriteCompletion como false.

Note que o atributo acks tem um enorme impacto no reconhecimento do registro.

Se não for possível escrever um registro, a mensagem é não reconhecida.

5.3. Contrapressão

O conector de saída do Kafka lida com a contrapressão, monitorando o número de mensagens em trânsito que aguardam gravação no broker do Kafka. O número de mensagens em trânsito é configurado usando o atributo max-inflight-messages e o padrão é 1024.

O conector envia apenas essa quantidade de mensagens ao mesmo tempo. Nenhuma outra mensagem será enviada até que pelo menos uma mensagem em andamento seja confirmada pelo broker. Em seguida, o conector grava uma nova mensagem no Kafka quando uma das mensagens em andamento do broker é reconhecida. Certifique-se de configurar o batch.size e o linger.ms do Kafka adequadamente.

Você também pode remover o limite de mensagens em andamento definindo max-inflight-messages como 0. No entanto, observe que o produtor do Kafka poderá bloquear se o número de solicitações atingir max.in.flight.requests.per.connection.

5.4. Nova tentativa de envio de mensagens

Quando o produtor Kafka recebe um erro do servidor, se for um erro transitório e recuperável, o cliente tentará enviar novamente o lote de mensagens. Esse comportamento é controlado pelos parâmetros retries e retry.backoff.ms. Além disso, a Mensageria Reativa do SmallRye tentará enviar novamente mensagens individuais em erros recuperáveis, dependendo dos parâmetros retries e delivery.timeout.ms.

Observe que, embora ter novas tentativas em um sistema confiável seja uma prática recomendada, o parâmetro max.in.flight.requests.per.connection tem como padrão 5, o que significa que a ordem das mensagens não é garantida. Se a ordem das mensagens for imprescindível para o seu caso de uso, definir max.in.flight.requests.per.connection como 1 garantirá que um único lote de mensagens seja enviado por vez, às custas de limitar a taxa de transferência do produtor.

Para aplicar um mecanismo de retentativa em erros de processamento, consulte a seção sobre Repetindo o processamento.

5.5. Tratando Falhas de Serialização

Para o cliente produtor do Kafka, as falhas de serialização não são recuperáveis e, portanto, o envio da mensagem não é repetido. Nesses casos, talvez seja necessário aplicar uma estratégia de falha para o serializador. Para isso, você precisa criar um bean que implemente a interface SerializationFailureHandler<T>:

@ApplicationScoped

@Identifier("failure-fallback") // Set the name of the failure handler

public class MySerializationFailureHandler

implements SerializationFailureHandler<JsonObject> { // Specify the expected type

@Override

public byte[] decorateSerialization(Uni<byte[]> serialization, String topic, boolean isKey,

String serializer, Object data, Headers headers) {

return serialization

.onFailure().retry().atMost(3)

.await().indefinitely();

}

}Para utilizar este manipulador de falhas, o bean deve ser exposto com o qualificador @Identifier e a configuração do conector deve especificar o atributo mp.messaging.outgoing.$channel.[key|value]-serialization-failure-handler (para serializadores de chave ou de valor).

O manipulador é chamado com detalhes da serialização, incluindo a ação representada como Uni<byte[]>. Observe que o método deve aguardar o resultado e retornar o vetor de bytes serializado.

5.6. Canais na memória

Em alguns casos de uso, é conveniente usar os padrões de mensagens para transferir mensagens dentro da mesma aplicação. Quando você não conecta um canal a um backend de mensagens como o Kafka, tudo acontece na memória, e os fluxos são criados encadeando métodos. Cada cadeia ainda é um fluxo reativo e aplica o protocolo de contrapressão.

A estrutura verifica se a cadeia produtor/consumidor está completa, o que significa que, se a aplicação gravar mensagens em um canal na memória (usando um método com apenas @Outgoing, ou um Emitter), ele também deverá consumir as mensagens de dentro da aplicação (usando um método com apenas @Incoming ou usando um fluxo não gerenciado).

5.7. Difusão de mensagens em vários consumidores

Por padrão, um canal pode ser vinculado a um único consumidor, usando o método @Incoming ou o fluxo reativo @Channel. Na inicialização da aplicação, os canais são verificados para formar uma cadeia de consumidores e produtores com um único consumidor e produtor. Você pode substituir esse comportamento definindo mp.messaging.$channel.broadcast=true em um canal.

No caso dos canais na memória, a anotação @Broadcast pode ser utilizada no método @Outgoing. Por exemplo,

import java.util.Random;

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import io.smallrye.reactive.messaging.annotations.Broadcast;

@ApplicationScoped

public class MultipleConsumer {

private final Random random = new Random();

@Outgoing("in-memory-channel")

@Broadcast

double generate() {

return random.nextDouble();

}

@Incoming("in-memory-channel")

void consumeAndLog(double price) {

System.out.println(price);

}

@Incoming("in-memory-channel")

@Outgoing("prices2")

double consumeAndSend(double price) {

return price;

}

}|

Reciprocamente, vários produtores no mesmo canal podem ser mesclados com a configuração |

A repetição da anotação @Outgoing nos métodos de saída ou de processamento permite outra maneira de enviar mensagens para vários canais de saída:

import java.util.Random;

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

@ApplicationScoped

public class MultipleProducers {

private final Random random = new Random();

@Outgoing("generated")

@Outgoing("generated-2")

double priceBroadcast() {

return random.nextDouble();

}

}No exemplo anterior, o preço gerado será transmitido para ambos os canais de saída. O exemplo a seguir envia seletivamente mensagens para vários canais de saída usando o objeto de contêiner Targeted, contendo key como nome do canal e value como conteúdo da mensagem.

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import io.smallrye.reactive.messaging.Targeted;

@ApplicationScoped

public class TargetedProducers {

@Incoming("in")

@Outgoing("out1")

@Outgoing("out2")

@Outgoing("out3")

public Targeted process(double price) {

Targeted targeted = Targeted.of("out1", "Price: " + price,

"out2", "Quote: " + price);

if (price > 90.0) {

return targeted.with("out3", price);

}

return targeted;

}

}Observe que a detecção automática para serializadores do Kafka não funciona para assinaturas usando o Targeted.

Informações detalhadas sobre a utilização da anotação @Blocking podem ser encontradas em Mensageria Reativa do SmallRye - Lindando com execução blocante.

5.8. Transações Kafka

As transações do Kafka permitem gravações atômicas em vários tópicos e partições do Kafka. O conector Kafka fornece o emissor personalizado KafkaTransactions para gravar registros do Kafka dentro de uma transação. Ele pode ser injetado como um emissor regular @Channel:

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Channel;

import io.smallrye.mutiny.Uni;

import io.smallrye.reactive.messaging.kafka.KafkaRecord;

import io.smallrye.reactive.messaging.kafka.transactions.KafkaTransactions;

@ApplicationScoped

public class KafkaTransactionalProducer {

@Channel("tx-out-example")

KafkaTransactions<String> txProducer;

public Uni<Void> emitInTransaction() {

return txProducer.withTransaction(emitter -> {

emitter.send(KafkaRecord.of(1, "a"));

emitter.send(KafkaRecord.of(2, "b"));

emitter.send(KafkaRecord.of(3, "c"));

return Uni.createFrom().voidItem();

});

}

}A função dada ao método withTransaction recebe um TransactionalEmitter para produzir registros e devolve um Uni que fornece o resultado da transação.

-

Se o processamento for concluído com êxito, o produtor é descarregado e a transação é confirmada.

-

Se o processamento lançar uma exceção, retornar uma

Unide falha, ou marcar oTransactionalEmitterpara abortar, a transação é abortada.

Os produtores transacionais do Kafka exigem a configuração da propriedade do cliente acks=all e um ID exclusivo para transactional.id, o que implica enable.idempotence=true. Quando o Quarkus detecta o uso de KafkaTransactions para um canal de saída, ele configura essas propriedades no canal, fornecendo um valor padrão de "${quarkus.application.name}-${channelName}" para a propriedade transactional.id.

Note que, para utilização em produção, o transactional.id deve ser único em todas as instâncias da aplicação.

|

Enquanto um emissor de mensagens normal suportaria chamadas simultâneas para os métodos Observe que, na Mensageria Reativa, a execução dos métodos de processamento já é serializada, a menos que Um exemplo de uso pode ser encontrado em Encadeando Transações do Kafka com transações Reativas do Hibernate. |

6. Requisição-Resposta do Kafka

O padrão de Requisição-Resposta do Kafka permite publicar um registro de requisição em um tópico do Kafka e, em seguida, aguardar um registro de resposta que responda à requisição inicial. O conector Kafka fornece o emissor personalizado KafkaRequestReply, que implementa o solicitante (ou cliente) do padrão de requisição-resposta para canais de saída do Kafka:

Ele pode ser injetado como um emissor @Channel regular:

import jakarta.enterprise.context.ApplicationScoped;

import jakarta.ws.rs.POST;

import jakarta.ws.rs.Path;

import jakarta.ws.rs.Produces;

import jakarta.ws.rs.core.MediaType;

import org.eclipse.microprofile.reactive.messaging.Channel;

import io.smallrye.mutiny.Uni;

import io.smallrye.reactive.messaging.kafka.reply.KafkaRequestReply;

@ApplicationScoped

@Path("/kafka")

public class KafkaRequestReplyEmitter {

@Channel("request-reply")

KafkaRequestReply<Integer, String> requestReply;

@POST

@Path("/req-rep")

@Produces(MediaType.TEXT_PLAIN)

public Uni<String> post(Integer request) {

return requestReply.request(request);

}

}O método de requisição publica o registro no tópico de destino configurado do canal de saída e consulta um tópico de resposta (por padrão, o tópico de destino com o sufixo -replies) em busca de um registro de resposta. Quando a resposta é recebida, o Uni retornado é concluído com o valor do registro. A operação de envio da requisição gera um ID de correlação e define um cabeçalho (por padrão, REPLY_CORRELATION_ID), que espera que seja enviado de volta no registro de resposta.

O respondendor pode ser implementado usando um processador de Mensageria Reativa (consulte Processando Mensagens).

For more information on Kafka Request Reply feature and advanced configuration options, see the SmallRye Reactive Messaging Documentation.

7. Processando Mensagens

As aplicações que transmitem dados geralmente precisam consumir alguns eventos de um tópico, processá-los e publicar o resultado em um tópico diferente. Um método processador pode ser implementado de forma simples usando as anotações @Incoming e @Outgoing:

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import jakarta.enterprise.context.ApplicationScoped;

@ApplicationScoped

public class PriceProcessor {

private static final double CONVERSION_RATE = 0.88;

@Incoming("price-in")

@Outgoing("price-out")

public double process(double price) {

return price * CONVERSION_RATE;

}

}O parâmetro do método process é o conteúdo da mensagem de entrada, enquanto o valor de retorno será usado como conteúdo da mensagem de saída. As assinaturas mencionadas anteriormente para os tipos de parâmetro e retorno também são compatíveis, como Message<T>, Record<K, V>, etc.

É possível aplicar o processamento assíncrono de fluxos consumindo e devolvendo o tipo de fluxo reativo Multi<T>:

import jakarta.enterprise.context.ApplicationScoped;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import io.smallrye.mutiny.Multi;

@ApplicationScoped

public class PriceProcessor {

private static final double CONVERSION_RATE = 0.88;

@Incoming("price-in")

@Outgoing("price-out")

public Multi<Double> process(Multi<Integer> prices) {

return prices.filter(p -> p > 100).map(p -> p * CONVERSION_RATE);

}

}7.1. Propagando a Chave de Registro

Ao processar mensagens, é possível propagar a chave do registro de entrada para o registro de saída.

Ativada com a configuração mp.messaging.outgoing.$channel.propagate-record-key=true, a propagação da chave de registro produz o registro de saída com a mesma chave do registro de entrada.

Se o registro de saída já contiver uma chave, ela não será substituída pela chave do registro de entrada. Se o registro de entrada tiver uma chave nula, será usada a propriedade mp.messaging.outgoing.$channel.key.

7.2. Processamento Exactly-Once (Exatamente Único)

O Kafka Transactions permite gerenciar os deslocamentos do consumidor dentro de uma transação, juntamente com as mensagens produzidas. Isso permite acoplar um consumidor a um produtor transacional em um padrão consume-transforma-produz, também conhecido como processamento exatamente único.

O emissor personalizado KafkaTransactions fornece uma forma de aplicar um processamento exatamente único a uma mensagem Kafka de entrada dentro de uma transação.

O exemplo seguinte inclui um lote de registros Kafka dentro de uma transação.

import jakarta.enterprise.context.ApplicationScoped;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.eclipse.microprofile.reactive.messaging.Channel;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Message;

import org.eclipse.microprofile.reactive.messaging.OnOverflow;

import io.smallrye.mutiny.Uni;

import io.smallrye.reactive.messaging.kafka.KafkaRecord;

import io.smallrye.reactive.messaging.kafka.transactions.KafkaTransactions;

@ApplicationScoped

public class KafkaExactlyOnceProcessor {

@Channel("prices-out")

@OnOverflow(value = OnOverflow.Strategy.BUFFER, bufferSize = 500) (3)

KafkaTransactions<Integer> txProducer;

@Incoming("prices-in")

public Uni<Void> emitInTransaction(Message<ConsumerRecords<String, Integer>> batch) { (1)

return txProducer.withTransactionAndAck(batch, emitter -> { (2)

for (ConsumerRecord<String, Integer> record : batch.getPayload()) {

emitter.send(KafkaRecord.of(record.key(), record.value() + 1)); (3)

}

return Uni.createFrom().voidItem();

});

}

}| 1 | Recomenda-se usar o processamento exatamente único junto com o modo de consumo em lote. Embora seja possível usá-lo com uma única mensagem do Kafka, isso terá um impacto significativo no desempenho. |

| 2 | A mensagem consumida é passada para o KafkaTransactions#withTransactionAndAck para lidar com os registros de offset e confirmação de mensagem. |

| 3 | O método send grava registros no Kafka dentro da transação, sem aguardar o recebimento do envio pelo broker. As mensagens pendentes de gravação no Kafka serão armazenadas em buffer e liberadas antes de confirmar a transação. Portanto, é recomendável configurar o @OnOverflow bufferSize para que caibam mensagens suficientes, por exemplo, o max.poll.records, quantidade máxima de registros retornados em um lote.

|

Ao usar o processamento exatamente único, as confirmações de deslocamento de mensagens consumidas são tratadas pela transação e, portanto, a aplicação não deve confirmar os deslocamentos por outros meios. O consumidor deve ter enable.auto.commit=false (o padrão) e definir explicitamente commit-strategy=ignore:

mp.messaging.incoming.prices-in.commit-strategy=ignore

mp.messaging.incoming.prices-in.failure-strategy=ignore7.2.1. Tratamento de erros para o processamento exatamente único

O Uni retornado do KafkaTransactions#withTransaction produzirá uma falha se a transação falhar e for abortada. A aplicação pode optar por tratar o caso de erro, mas se um Uni com falha for retornado do método @Incoming, o canal de entrada falhará efetivamente e interromperá o fluxo reativo.

O método KafkaTransactions#withTransactionAndAck reconhece e não reconhece a mensagem, mas não retornará um Uni com falha. As mensagens não reconhecidas serão tratadas pela estratégia de falha do canal de entrada (veja Estratégias de Tratamento de Erros). Configurar failure-strategy=ignore simplesmente redefine o consumidor Kafka para os últimos deslocamentos confirmados e retoma o consumo a partir daí.

8. Acessando clientes Kafka diretamente

Em casos raros, você pode precisar acessar os clientes Kafka subjacentes. KafkaClientService fornece acesso thread-safe a Producer e Consumer.

import jakarta.enterprise.context.ApplicationScoped;

import jakarta.enterprise.event.Observes;

import jakarta.inject.Inject;

import org.apache.kafka.clients.producer.ProducerRecord;

import io.quarkus.runtime.StartupEvent;

import io.smallrye.reactive.messaging.kafka.KafkaClientService;

import io.smallrye.reactive.messaging.kafka.KafkaConsumer;

import io.smallrye.reactive.messaging.kafka.KafkaProducer;

@ApplicationScoped

public class PriceSender {

@Inject

KafkaClientService clientService;

void onStartup(@Observes StartupEvent startupEvent) {

KafkaProducer<String, Double> producer = clientService.getProducer("generated-price");

producer.runOnSendingThread(client -> client.send(new ProducerRecord<>("prices", 2.4)))

.await().indefinitely();

}

}|

A |

Você também pode obter a configuração do Kafka injetada na sua aplicação e criar diretamente clientes produtores, consumidores e administradores do Kafka:

import io.smallrye.common.annotation.Identifier;

import org.apache.kafka.clients.admin.AdminClient;

import org.apache.kafka.clients.admin.AdminClientConfig;

import org.apache.kafka.clients.admin.KafkaAdminClient;

import jakarta.enterprise.context.ApplicationScoped;

import jakarta.enterprise.inject.Produces;

import jakarta.inject.Inject;

import java.util.HashMap;

import java.util.Map;

@ApplicationScoped

public class KafkaClients {

@Inject

@Identifier("default-kafka-broker")

Map<String, Object> config;

@Produces

AdminClient getAdmin() {

Map<String, Object> copy = new HashMap<>();

for (Map.Entry<String, Object> entry : config.entrySet()) {

if (AdminClientConfig.configNames().contains(entry.getKey())) {

copy.put(entry.getKey(), entry.getValue());

}

}

return KafkaAdminClient.create(copy);

}

}O mapa de configuração default-kafka-broker contém todas as propriedades da aplicação prefixadas com kafka. ou KAFKA_. Para mais opções de configuração, consulte Resolução de Configuração do Kafka.

9. Serialização JSON

O Quarkus tem capacidades incorporadas para lidar com mensagens JSON Kafka.

Imagine que temos uma classe de dados Fruit da seguinte forma:

public class Fruit {

public String name;

public int price;

public Fruit() {

}

public Fruit(String name, int price) {

this.name = name;

this.price = price;

}

}E queremos utilizá-la para receber mensagens do Kafka, fazer alguma transformação de preços e enviar mensagens de volta para o Kafka.

import io.smallrye.reactive.messaging.annotations.Broadcast;

import org.eclipse.microprofile.reactive.messaging.Incoming;

import org.eclipse.microprofile.reactive.messaging.Outgoing;

import jakarta.enterprise.context.ApplicationScoped;

/**

* A bean consuming data from the "fruit-in" channel and applying some price conversion.

* The result is pushed to the "fruit-out" channel.

*/

@ApplicationScoped

public class FruitProcessor {

private static final double CONVERSION_RATE = 0.88;

@Incoming("fruit-in")

@Outgoing("fruit-out")

@Broadcast

public Fruit process(Fruit fruit) {

fruit.price = fruit.price * CONVERSION_RATE;

return fruit;

}

}Para isso, precisamos configurar a serialização JSON com Jackson ou JSON-B.

Com a serialização JSON corretamente configurada, também é possível utilizar Publisher<Fruit> e Emitter<Fruit>.

|

9.1. Serialização via Jackson

O Quarkus possui suporte embutido para serialização e desserialização JSON baseado no Jackson. Ele também irá gerar o serializador e desserializador para você, então você não precisa configurar nada. Quando a geração está desativada, você pode usar os ObjectMapperSerializer e ObjectMapperDeserializer fornecidos, como explicado abaixo.

Existe um ObjectMapperSerializer que pode ser usado para serializar todos os objetos de dados via Jackson. Você pode criar uma subclasse vazia se quiser usar Detecção automática de serializador/desserializador.

Por padrão, o ObjectMapperSerializer serializa null como a String "null". Isso pode ser personalizado com a definição da propriedade de configuração do Kafka json.serialize.null-as-null=true, que serializará null como null. Isso é útil quando se usa um tópico compactado, pois null é usado como uma tombstone para saber quais mensagens são excluídas durante a fase de compactação.

|

A classe correspondente do desserializador precisa ser uma subclasse. Portanto, vamos criar um FruitDeserializer que estende o ObjectMapperDeserializer.

package com.acme.fruit.jackson;

import io.quarkus.kafka.client.serialization.ObjectMapperDeserializer;

public class FruitDeserializer extends ObjectMapperDeserializer<Fruit> {

public FruitDeserializer() {

super(Fruit.class);

}

}Por fim, configure os seus canais para utilizarem o serializador e desserializador Jackson.

# Configure the Kafka source (we read from it)

mp.messaging.incoming.fruit-in.topic=fruit-in

mp.messaging.incoming.fruit-in.value.deserializer=com.acme.fruit.jackson.FruitDeserializer

# Configure the Kafka sink (we write to it)

mp.messaging.outgoing.fruit-out.topic=fruit-out

mp.messaging.outgoing.fruit-out.value.serializer=io.quarkus.kafka.client.serialization.ObjectMapperSerializerAgora, suas mensagens Kafka conterão uma representação serializada pelo Jackson do seu objeto de dados Fruit. Nesse caso, a configuração do deserializer não é necessária, pois a Detecção automática de serializador/desserializador está habilitada por padrão.

Se você pretende desserializar uma lista de fruits, tem de criar um desserializador com um Jackson TypeReference denotando a coleção genérica utilizada.

package com.acme.fruit.jackson;

import java.util.List;

import com.fasterxml.jackson.core.type.TypeReference;

import io.quarkus.kafka.client.serialization.ObjectMapperDeserializer;

public class ListOfFruitDeserializer extends ObjectMapperDeserializer<List<Fruit>> {

public ListOfFruitDeserializer() {

super(new TypeReference<List<Fruit>>() {});

}

}9.2. Serialização via JSON-B

Em primeiro lugar, é necessário incluir a extensão quarkus-jsonb.

<dependency>

<groupId>io.quarkus</groupId>

<artifactId>quarkus-jsonb</artifactId>

</dependency>implementation("io.quarkus:quarkus-jsonb")Existe um JsonbSerializer que pode ser usado para serializar todos os objetos de dados via JSON-B. Você pode criar uma subclasse vazia se quiser usar Detecção automática de serializador/desserializador.

Por padrão, o JsonbSerializer serializa null como a String "null". Isso pode ser personalizado com a definição da propriedade de configuração do Kafka json.serialize.null-as-null=true, que serializará null como null. Isso é útil quando se usa um tópico compactado, pois null é usado como uma tombstone para saber quais mensagens são excluídas durante a fase de compactação.

|

A classe correspondente do desserializador precisa ser uma subclasse. Portanto, vamos criar um FruitDeserializer que estende o genérico JsonbDeserializer.

package com.acme.fruit.jsonb;

import io.quarkus.kafka.client.serialization.JsonbDeserializer;

public class FruitDeserializer extends JsonbDeserializer<Fruit> {

public FruitDeserializer() {

super(Fruit.class);

}

}Por fim, configure os seus canais para utilizarem o serializador e desserializador JSON-B.

# Configure the Kafka source (we read from it)

mp.messaging.incoming.fruit-in.connector=smallrye-kafka

mp.messaging.incoming.fruit-in.topic=fruit-in

mp.messaging.incoming.fruit-in.value.deserializer=com.acme.fruit.jsonb.FruitDeserializer

# Configure the Kafka sink (we write to it)

mp.messaging.outgoing.fruit-out.connector=smallrye-kafka

mp.messaging.outgoing.fruit-out.topic=fruit-out

mp.messaging.outgoing.fruit-out.value.serializer=io.quarkus.kafka.client.serialization.JsonbSerializerAgora, as suas mensagens Kafka conterão uma representação serializada JSON-B do seu objeto de dados Fruit.

Para desserializar uma lista de fruits, é necessário criar um desserializador com um Tipo denotando a coleção genérica utilizada.

package com.acme.fruit.jsonb;

import java.lang.reflect.Type;

import java.util.ArrayList;

import java.util.List;

import io.quarkus.kafka.client.serialization.JsonbDeserializer;

public class ListOfFruitDeserializer extends JsonbDeserializer<List<Fruit>> {

public ListOfFruitDeserializer() {

super(new ArrayList<MyEntity>() {}.getClass().getGenericSuperclass());

}

}

Se não quiser criar um desserializador para cada objeto de dados, você pode usar o genérico io.vertx.kafka.client.serialization.JsonObjectDeserializer que desserializará para um io.vertx.core.json.JsonObject. O serializador correspondente também pode ser usado: io.vertx.kafka.client.serialization.JsonObjectSerializer.

|

10. Serialização Avro

Isso é descrito em um guia dedicado: Usando Apache Kafka com Registro de Esquema e o Avro.

11. Serialização do Esquema JSON

Isso é descrito em um guia dedicado: Usando Apache Kafka com Registro de Esquema e Esquema JSON.

12. Detecção automática de serializador/desserializador

Ao usar a Mensageria Quarkus com Kafka (io.quarkus:quarkus-messaging-kafka), o Quarkus pode frequentemente detectar automaticamente a classe correta de serializador e desserializador. Essa detecção automática é baseada nas declarações dos métodos @Incoming e @Outgoing, assim como nos @Channels injetados.

Por exemplo, se você declarar

@Outgoing("generated-price")

public Multi<Integer> generate() {

...